|

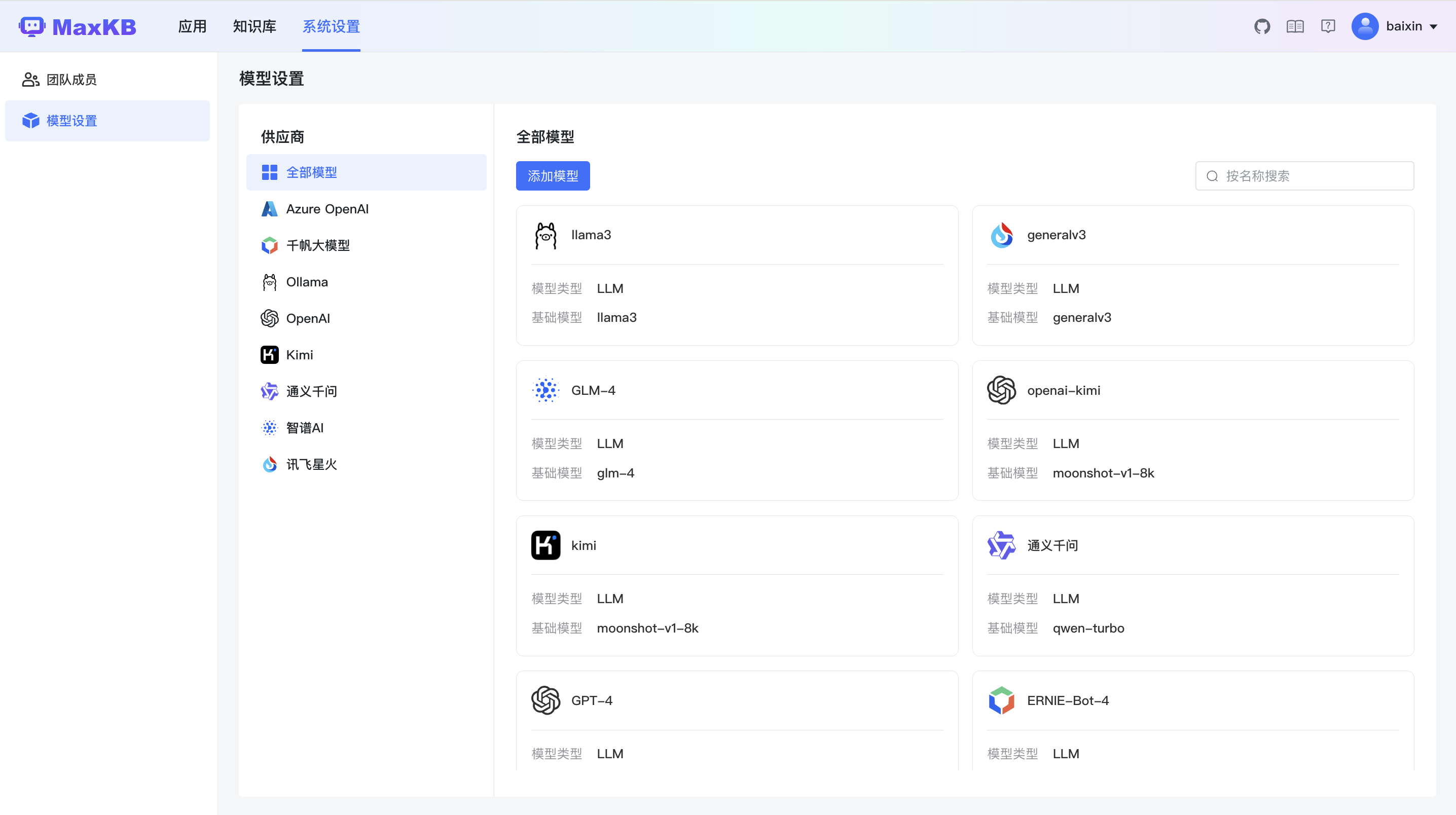

python基于 LLM 大语言模型的知识库问答系统,开箱即用多模型支持 基于 LLM 大语言模型的知识库问答系统 MaxKB 是一款基于 LLM 大语言模型的知识库问答系统。MaxKB = Max Knowledge Base,旨在成为企业的最强大脑。 功能概述快速开始

- docker run -d --name=maxkb -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data 1panel/maxkb

- # 用户名: admin

- # 密码: MaxKB@123..

你也可以通过 1Panel 应用商店 快速部署 MaxKB + Ollama + Llama 2,30 分钟内即可上线基于本地大模型的知识库问答系统,并嵌入到第三方业务系统中。 如果是内网环境,推荐使用 离线安装包 进行安装部署。 你也可以在线体验:DataEase 小助手,它是基于 MaxKB 搭建的智能问答系统,已经嵌入到 DataEase 产品及在线文档中。 技术选型技术栈1 安装部署1.1 环境要求安装前请确保您的系统符合安装条件: 1.2 在线快速部署1.MaxKB 支持一键启动,仅需执行以下命令: - docker run -d --name=maxkb -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data 1panel/maxkb

2.安装成功后,可通过浏览器访问 MaxKB: - http://目标服务器 IP 地址:目标端口

- 默认登录信息

- 用户名:admin

- 默认密码:MaxKB@123..

如果使用的是云服务器,请至安全组开放目标端口。 1.3 离线部署 (生产环境推荐使用该方式部署)注意:离线包仅支持x86服务器。 1.打开社区网站下载 MaxKB 离线包 社区版离线包 2.上传至服务器后进行解压缩,执行以下命令: - # maxkb-v1.2.0-offline.tar.gz替换成下载包的名字

- tar -zxvf maxkb-v1.2.0-offline.tar.gz

3.安装 MaxKB, 执行以下命令: - # 进入安装包解压缩后目录

- cd maxkb-v1.2.0-offline

- # 执行安装命令

- bash install.sh

4.安装成功后,可通过浏览器访问 MaxKB: - http://目标服务器 IP 地址:8080

- 默认登录信息

- 用户名:admin

- 默认密码:MaxKB@123..

python基于 LLM 大语言模型的知识库问答系统,开箱即用多模型支持

python基于 LLM 大语言模型的知识库问答系统,开箱即用多模型支持

python基于 LLM 大语言模型的知识库问答系统,开箱即用多模型支持

python基于 LLM 大语言模型的知识库问答系统,开箱即用多模型支持

游客,本帖隐藏的内容需要积分高于 2 才可浏览,您当前积分为 0 提取码下载:

|  |免责声明|小黑屋|依星资源网

( 鲁ICP备2021043233号-3 )|网站地图

|免责声明|小黑屋|依星资源网

( 鲁ICP备2021043233号-3 )|网站地图