一个模块化的交互数字人对话实现,能够在单台PC上运行完整功能。

核心亮点- 低延迟数字人实时对话:平均回答延迟在2.2秒左右。

- 多模态语言模型:支持多模态语言模型,包括文本、音频、视频等。

- 模块化设计:使用模块化的设计,可以灵活地替换组件,实现不同功能组合。

更新日志- [2025.06.12] 版本 0.4.1发布:

- 增加对MuseTalk数字人的支持,支持自定义形象(底版视频自定义)

- 50个LiteAvatar新形象发布,丰富各种职业角色,请见LiteAvatarGallery

- [2025.04.18] 版本 0.3.0发布:

- 热烈祝贺LAM论文被SIGGRAPH 2025接收!

- 增加对LAM数字人 (能够单图秒级打造超写实3D数字人的开源项目) 的支持

- 增加使用百炼API的tts handler,可以大幅减少对GPU的依赖

- 增加对微软Edge TTS的支持

- 现在使用uv进行python的包管理,依赖可以按照配置中所激活的handler进行安装

- CSS响应式布局更新

- [2025.04.14] 版本 0.2.2发布:

- 100个LiteAvatar新形象发布,请见LiteAvatarGallery

- 默认使用GPU后端运行数字人lite-avata

- [2025.04.07] 版本 0.2.1发布:

- 增加历史记录支持

- 支持文本输入

- 启动时不再强制要求摄像头存在

- 优化模块化加载方式

- [2025.02.20] 版本 0.1.0发布:

- 模块化的实时交互对话数字人

- 支持MiniCPM-o作为多模态语言模型和云端的 api 两种调用方

ModelScope和 HuggingFace上均部署了一个体验服务,音频部分采用SenseVoice + Qwen-VL + CosyVoice实现,可以对LiteAvatar和LAM两种数字人能力进行切换,欢迎体验。

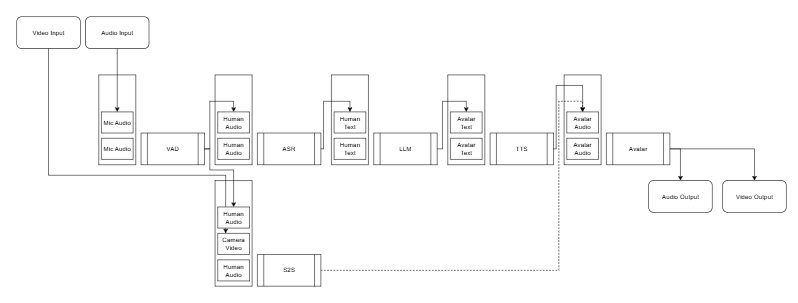

一个模块化的交互数字人对话实现,能够在单台PC上运行完整功能。目前支持MiniCPM-o作为多模态语言模型或者使用云端的 api 替换实现常规的ASR + LLM + TTS。这两种模式的结构如下图所示。

一个模块化的交互数字人对话实现,能够在单台PC上运行完整功能。

系统需求- Python版本 >=3.11.7

- 支持CUDA的GPU

- 未量化的多模态语言模型MiniCPM-o需要20GB以上的显存。

- 数字人部分可以使用GPU/CPU进行推理,测试设备CPU为i9-13980HX,CPU推理下可以达到30FPS.

性能指标在我们的测试中,使用配备 i9-13900KF 处理器和 Nvidia RTX 4090 显卡的 PC,我们记录了回答的延迟时间。经过十次测试,平均延迟约为 2.2 秒。延迟时间是从用户语音结束到数字人开始语音的时间间隔,其中包含了 RTC 双向数据传输时间、VAD(语音活动检测)停止延迟以及整个流程的计算时间。

组件依赖[td]| 类型 | 开源项目 |

|

| | RTC | HumanAIGC-Engineering/gradio-webrtc |

| | | VAD | snakers4/silero-vad |

| | | LLM | OpenBMB/MiniCPM-o |

|

| | LLM-int4 | OpenBMB/MiniCPM-o |

|

| | Avatar | HumanAIGC/lite-avatar |

| | | TTS | FunAudioLLM/CosyVoice |

| | | Avatar | aigc3d/LAM_Audio2Expression |

|

| | facebook/wav2vec2-base-960h | |

| | Avatar | TMElyralab/MuseTalk |

链接:https://pan.quark.cn/s/bdd8ddf78fb6

提取码下载:

|  |免责声明|小黑屋|依星资源网

( 鲁ICP备2021043233号-3 )|网站地图

|免责声明|小黑屋|依星资源网

( 鲁ICP备2021043233号-3 )|网站地图