一款基于 llama.cpp 和 stable-diffusion.cpp 的 LM 推理服务器(纯 API,无前端资产)

特征- 与 OpenAI 聊天 API 兼容。

- 支持 OpenAI Function 调用 API。

- LLaMA3 系列

- 花岗岩系列

- Mistral 系列

- Hermes2 / Qwen2 系列

- ChatGLM4 系列

- CommandR 系列(带/--jinja)

- FunctionaryV3 系列 (带/--jinja)

- DeepSeekR1 系列 (带 , 实验性)--jinja

- ...

- 与 OpenAI Embeddings API 兼容。

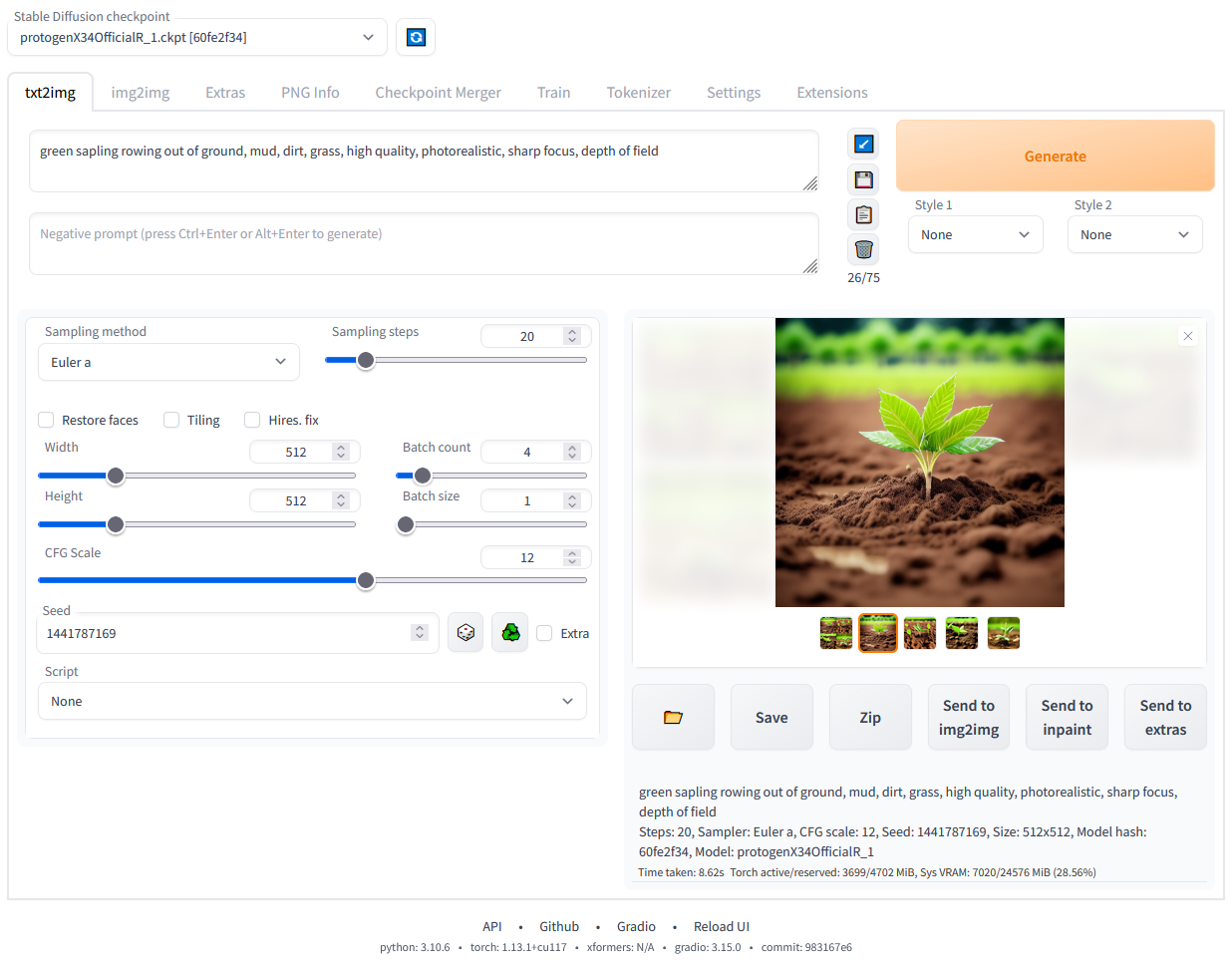

- 兼容 OpenAI Images API, 请参阅我们的图片集。

- 与(旧版)OpenAI Completions API 兼容。

- 兼容 Jina Rerank API, 请参阅我们的 Reranker 集合。

- 支持推测解码:draft model 或 n-gram lookup。

- 支持 RPC 服务器模式,可以作为远程推理后端。

- 对于非图像模型,跨多个设备(包括远程 RPC 服务器)拆分卸载层。

- 支持 OpenAI Chat Vision API。

- LLaVA 系列(带或--chat-tempalte llava--chat-template llava-mistral)

- MiniCPM VL 系列

- Qwen2 VL 系列

- GLM-Edge-V 系列(带--chat-template llava)

- Granite VL 系列

- Gemma3 VL 系列

- SmolVLM 系列

- Pixtral 系列

- MobileVLM 系列(带--chat-template deepseek)

- Mistral Small 3.1 (带/--chat-template mistral-v7)

- Qwen2.5 VL 系列,请 使用 ggml-org/Qwen2.5-VL-3B-Instruct-GGUF 存储库, 或由 ggml-org/llama.cpp#12402 转换的模型文件。 流行的 Mungert/Qwen2.5-VL-*B-Instruct-GGUF 存储库已损坏。

- InternVL2/InternVL3 系列

一款基于 llama.cpp 和 stable-diffusion.cpp 的 LM 推理服务器(纯 API,无前端资产) ...

链接:https://pan.quark.cn/s/556bbf8ec8ac

提取码下载:

|  |免责声明|小黑屋|依星资源网

( 鲁ICP备2021043233号-3 )|网站地图

|免责声明|小黑屋|依星资源网

( 鲁ICP备2021043233号-3 )|网站地图